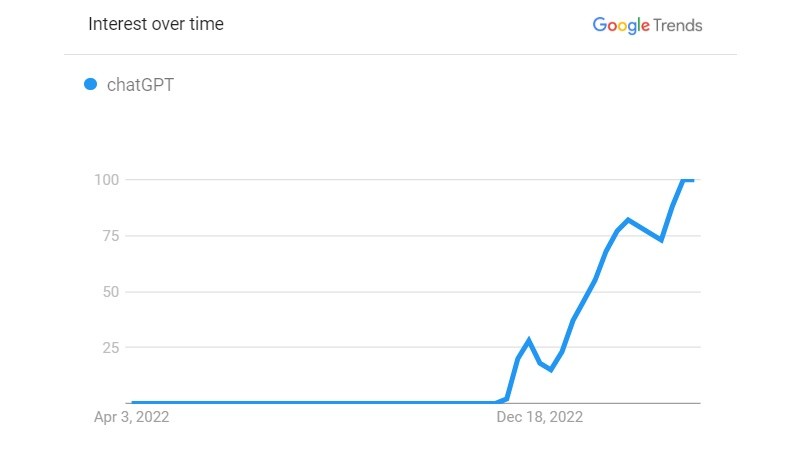

Por estos días, la estrella más brillante en el firmamento de las inteligencias artificiales es ChatGPT, de la empresa californiana OpenAI. Desde su lanzamiento al público general a finales del año pasado, su habilidad para interactuar con los usuarios conversando con naturalidad y respondiendo preguntas de forma convincente lo volvió viral. En menos de una semana superó el millón de usuarios y para enero ya había superado la marca de los 100 millones. Para ponerlo en contexto, TikTok, una de las redes sociales más populares del mundo, tardó 9 meses en alcanzar esa cifra.

ChatGPT está específicamente diseñado para procesar lenguaje natural, una rama de la inteligencia artificial que se enfoca en la interacción entre humanos y computadoras a través del uso de la lengua tal como lo usamos las personas. Así es que puede entender el contexto y las palabras en una charla, respondiendo con oraciones complejas y coherentes, siguiendo el hilo de la conversación.

Para lograr esto, el sistema fue entrenado con un conjunto de datos enorme recopilados por Common Crawl, una organización sin fines de lucro que desde el año 2008 rastrea y reúne información de miles de millones de páginas web de todo el mundo. También fue alimentado con una cantidad gigantesca de textos de todo tipo y géneros: noticias, libros, artículos, publicaciones en redes sociales, comentarios de usuarios en foros y hasta descripciones de productos. Expuesto a estas cantidades masivas de información, el modelo aprende a entender el lenguaje humano con efectividad y pueden generarlo de manera acorde.

Si bien los chatbots existen hace muchos años, la sofisticación y los recursos de ChatGPT lo llevaron inmediatamente a los titulares periodísticos. Sin embargo, la tinta no había terminado de secar del todo cuando a mediados de marzo OpenAI presentó una nueva iteración de su producto estrella: ChatGPT-4. Ahí si, la locura fue total.

Si bien ambos modelos pueden realizar actividades similares, GPT-4 supera ampliamente a su versión anterior gracias a mejoras significativas en su precisión y exactitud en las respuestas. Además, adquirió nuevas habilidades, ahora puede comprender imágenes, entender memes, explicar chistes o incluso generar código a partir de un esquema trazado a mano.

El sistema es tan poderoso que, según las propias investigaciones de OpenAI, el impacto que un modelo como este puede llegar a tener en el mercado laboral es considerable. Algunos empleos, como los de matemáticos, contadores, analistas financieros, escritores, periodistas, diseñadores gráficos y web, están expuestos a ser reemplazados totalmente por esta tecnología.

En ese sentido, el lunes, la banca de inversión Goldman Sachs publicó un informe en el que resalta que los modelos generativos como ChatGPT, que tienen la capacidad de generar contenido indistinguible de la producción humana, podrían impulsar un aumento de la productividad que podría elevar el PIB global anual en un 7% durante un período de 10 años. Sin embargo, al mismo tiempo dejaría fuera del mundo del empleo al equivalente a 300 millones de trabajadores de jornada completa en las economías desarrolladas.

Fredi Vivas es especialista en inteligencia artificial y ciencia de datos, además de CEO y fundador de RockingData, una de las 10 empresas emergentes más prometedoras de Argentina. Para él, la IA podría ser una amenaza en el caso de que no se comprenda bien cómo utilizarla. “Si se aplica mal, en el sentido de pensar que la Inteligencia artificial va a resolver todo, eso sí puede ser riesgoso. En cambio, si se entiende para qué se puede usar, cómo funciona y cómo complementa el trabajo de las personas, esa responsabilidad y ese entendimiento van a llevar a conseguir grandes mejoras en todo lo que hacemos, desde el mundo de la educación hasta el mundo de la salud y los negocios”, explica.

También este lunes, Europol alertó que los criminales podrían utilizar ChatGPT para perfeccionar una amplia gama de actividades delictivas. Desde fraude e ingeniería social, optimizando la redacción de textos para campañas de phishing, hasta la generación de código malicioso que permita llevar adelante ciberataques a delincuentes con pocos conocimientos técnicos. Para infundir miedo a la población, la agencia policial europea no ahorró en creatividad, también adelantó que con ChatGPT los malhechores podrían acceder fácilmente a información para ingresar ilegalmente a viviendas, realizar ataques terroristas e incluso abusar sexualmente de menores.

Para Vivas, autor del libro “¿Cómo piensan las máquinas?“ y coordinador del programa “Data & AI Strategy” de la Universidad de San Andrés, “el peligro de la inteligencia artificial es que la apliquemos mal, y eso viene mucho de no entender cómo funciona. Por ejemplo, un caso: en el Mundial estaba el VAR semiautomático, que con IA detectaba posiciones que podrían ser adelantadas o no. La Inteligencia artificial solo detectaba algunas cuestiones de la posición de la pelota y los jugadores y daba información para que los árbitros tomen la decisión final, así estaba creado el modelo de toma de decisiones en base al VAR semiautomático. Sin embargo, se veía que muchos árbitros decidían casi sin dudar de lo que estaban viendo con la Inteligencia artificial. Era como sacarse un problema de encima. Eso es una mala implementación, porque lo que buscamos acá es que el humano esté empoderado con nueva información para tomar la decisión más precisa posible, no que tome la decisión la máquina. Y ese error conceptual puede llevarnos a crear modelos que no tengan una visión humana, lo que sería bastante grave para el mundo”, detalla.

El miércoles, científicos, expertos en IA y personalidades de la tecnología solicitaron a través de una carta abierta que se detenga al menos por seis meses el desarrollo y las pruebas de tecnologías más potentes que ChatGPT-4, entre ellas GPT-5 . El escrito fue publicado por el Future of Life Institute, una organización que trabaja en para reducir los riesgos potenciales que enfrenta la humanidad como consecuencia de la inteligencia artificial avanzada. Entre los firmantes se encuentran Steve Wozniak, cofundador de Apple Inc, Yoshua Bengio, de DeepMind, Jack Dorsey, el creador de Twitter y Elon Musk.

“Sobre la carta, hay que entender también que mucho de lo que aparece ahí quizás son algunas cuestiones políticas que nosotros no conocemos”, precisa el ingeniero Vivas. “Ahí hay personas como Elon Musk que trabajaron y fueron fundadores de OpenAI, entonces hay un vínculo comercial-político que desconocemos”.

OpenAI fue lanzada en 2015 con el respaldo de importantes multimillonarios como Musk y Reid Hoffman. Sin embargo, en 2018, preocupado porque OpenAI se encontraba detrás de Google en el desarrollo de modelos de inteligencia artificial, Musk propuso tomar el control de la organización, iniciativa que fue rechazada por los otros fundadores. Musk entonces abandonó OpenAI, cancelando todo tipo de financiación. Para Musk, quien tiene un ego aún más grande que su fortuna, saber que ayudó a fundar la compañía más disruptiva de los últimos años y luego la abandonó debe ser algo bastante doloroso.

“Pero al margen de eso, no sé si es una buena idea”, analiza el especialista. “Se pueden frenar algunos de los grandes desarrollos de tecnología de Inteligencia artificial, pero por otro lado, otros pueden seguir ocurriendo, entonces no sé si esa es la solución. Para mí está bueno que se instale la conversación. No detenerla, sino pensar cómo hacemos para aplicarla éticamente, cómo informamos a la gente, ¿incluimos esto como parte de la currícula dentro de todas las universidades y escuelas del mundo? Bueno, son nuevas preguntas, que para mí son las que tienen más sentido hacerse”, reflexiona.

Este viernes, la autoridad italiana de protección de datos, GPDP, emitió una prohibición temporal a ChatGPT alegando múltiples violaciones al actual Reglamento General de Protección de Datos europeo (GDPR), entre los que se incluye el procesamiento ilegal de datos de los usuarios y la falta de implementación de mecanismos que eviten que menores de 13 años accedan al chatbot. La agencia reguladora otorgó a OpenAI un plazo de 20 días para comunicar las medidas adoptadas. De no hacerlo, podría enfrentar una multa de 20 millones de euros o de hasta el 4% de la facturación global anual. El veto impuesto por Italia podría impulsar a otros países europeos a tomar medidas similares.

Vivas no duda en que, más temprano que tarde, la IA será regulada. “Ya hay algunas cuestiones que están dándose, como la recomendación de uso ético y responsable creada por la Unesco, o las modificaciones en el Reglamento General de Protección de Datos (GDPR) en Europa. Hay ideas sobre hacer auditorías a algoritmos para que dejen de ser una caja negra y sean más transparentes, que se entienda lo que está pasando detrás de cada una de las inteligencias artificiales. Todo esto seguramente será legislado y regulado. Eso es correcto, siempre y cuando no bloquee la innovación, o al menos equilibre, ¿no? Quizás no se va a innovar tan rápido, quizás no van a conseguir resultados como lo estamos viendo hoy, pero que sea beneficioso para la sociedad”, concluye.

Tenemos la fortuna de ser privilegiados testigos de la historia. Una nueva era tecnológica surge delante de nuestros ojos, con el potencial de cambiar los destinos de la humanidad como una fuerza para el bien. Más allá del potencial apocalipsis que anuncian los infaltables agoreros y tremendistas, con una regulación adecuada y una investigación responsable que equilibre ética con innovación, las inteligencias artificiales generativas no solo podrán ser seguras, sino también beneficiosas para la sociedad.